Computación y ciencia de datos.

El BIFI es uno de los centros de e-ciencia más relevantes en España, tanto como proveedores de recursos como por los usuarios científicos. Compuesta principalmente por ingenieros y físicos, el Área de Computación y Ciencia de Datos incluye una amplia gama de actividades, investigación tecnológica, apoyo a usuarios, investigación aplicada, transferencia de tecnología, difusión.

El BIFI aloja el Centro de Supercomputación de Aragón (Cesar), una infraestructura de cómputo que abarca un amplio conjunto de tecnologías: HPC (memoria distribuida y compartida), grid, cloud, computación voluntaria y ordenadores dedicados.

De hecho, el Área de Computación y Ciencia de Datos se estructura en cinco líneas de investigación:

- Ciencia Ciudadana

- Análisis de Datos, Visualización Avanzada y Transferencia Tecnológica

- Computación de Alto Rendimiento y Cloud Computing (HPC-Cloud)

- Ordenadores Dedicados

- Ciencia Digital

- Modelos estocásticos y análisis de datos en Medicina y Climatología

Los recursos de computación HPC ofrecen varios millones de horas de CPU y cientos de terabytes de almacenamiento por año, a los investigadores del BIFI (y sus

colaboradores) y a usuarios externos a través de la Red Española de Supercomputación, el programa Hosted Clusters y otros servicios prestados.

También las infraestructuras Cloud proporcionan recursos informáticos a una amplia gama de investigaciones, que tienen requisitos específicos o complementarios a los ofrecidos por las infraestructuras HPC. Además de esto, también sirven como banco de pruebas para empresas y pymes españolas y europeas, que están dispuestas a adoptar estas tecnologías para mejorar su modelo de negocio. Por lo tanto, en los últimos años, hemos centrado nuestra investigación y las infraestructuras cloud para ayudar a las PYME sobre cómo obtener ventaja de estas poderosas tecnologías.

En la línea de investigación de ordenadores de propósito especial, se trabaja en el diseño y construcción de máquinas dedicadas a resolver problemas muy específicos, como el premiado superordenador JANUS, basado en FPGAs y con relevantes resultados científicos.

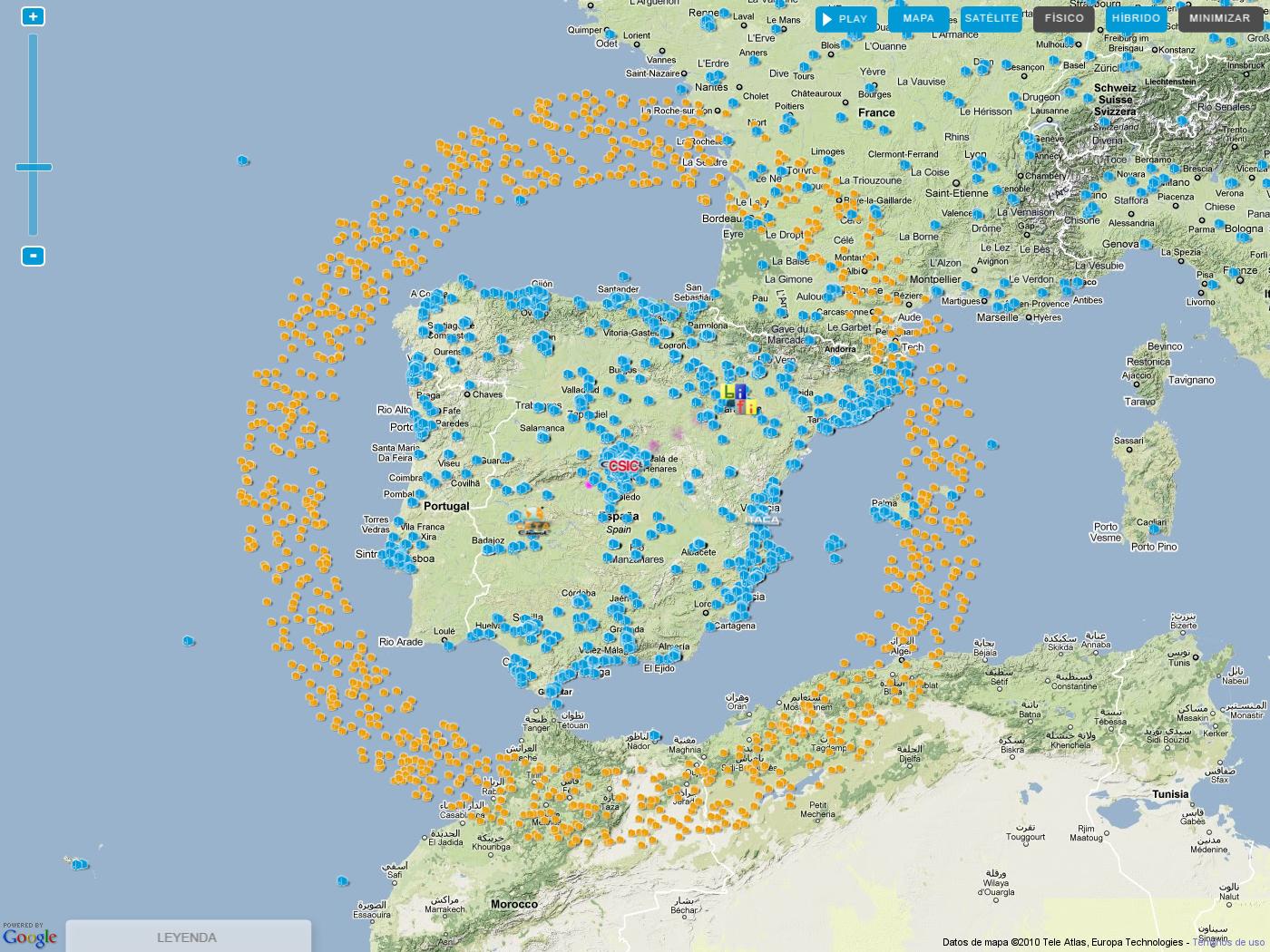

BIFI es una referencia internacional en actividades de ciencia ciudadana y lidera el proyecto de computación voluntaria Ibercivis.

- Ciencia Ciudadana

- Análisis de Datos, Visualización Avanzada y Transferencia Tecnológica

- Computación de alto rendimiento y cloud computing (HPC-CLOUD)

- Ordenadores Dedicados

- Ciencia Digital

- Modelos estocásticos y análisis de datos en Medicina y Climatología

Ciencia Ciudadana

Responsable de la Línea de Investigación:

Jesús Clemente

Investigadores:

Francisco Sanz

Cristina Hernández

Mari Carmen Ibáñez

RESUMEN

La ciencia ciudadana es una línea de investigación que promueve la participación de la sociedad en la ciencia. El primer proyecto que surgió en este marco y que sigue aún en funcionamiento fue Ibercivis, en el que los ciudadanos podían colaborar con la investigación compartiendo los recursos computacionales en sus tiempos informáticos inactivos.

Entre los principales objetivos de esta prometedora línea de investigación se encuentran: reconocer el potencial de la ciencia ciudadana y el papel de la sociedad, así como la importancia de la participación activa de los ciudadanos en diferentes actividades de carácter científico. En los últimos años, las contribuciones en este sentido han aumentado considerablemente y tienen un gran valor añadido para los investigadores, en general. El Instituto BIFI apoya y promueve esta tarea, permitiendo a los ciudadanos hacer uso de los recursos y de la infraestructura computacional a través de diferentes actividades como el análisis de datos y el desarrollo de experimentos en diversos campos científicos. De esta manera, los voluntarios pueden participar en la investigación y contribuir a la ciencia.

Además de desarrollar nuestras propias herramientas, proyectos científicos ciudadanos y experimentos participativos en colaboración con investigadores y ciudadanos, el grupo ha coordinado: «Socientize». Este proyecto propuso una serie de recomendaciones útiles para contribuir a la mejora de la estrategia de participación ciudadana o pública en las actividades europeas de investigación científica en el programa Horizonte 2020. Todas estas propuestas están incluidas en el Libro Blanco sobre Ciencia Ciudadana para Europa. Varios servicios de la Comisión (DGs CONNECT, RTD, JRC) utilizan este documento como referencia.

PUBLICACIONES RELEVANTES

1.- White Paper on Citizen Science for Europe.

2.- Socientize Consortium 2013. Green Paper on Citizen Science — Citizen Science for Europe: Towards a better society of empowered citizens and enhanced research, November, 2013.

3.- Cell Spotting: Educational and Motivational Outcomes of Cell Biology Citizen Science Project in the Classroom. Cândida G. Silva, António Monteiro, Caroline Manahl, Eduardo Lostal, Teresa Holocher-Ertl, Nazareno Andrade, Francisco Brasileiro, Paulo Gama Mota, Fermín Serrano Sanz, José A. Carrodeguas, Rui M. M. Brito (2015). JCOM – Journal of Science Communication – “Citizen Science” Special Issue (accepted for publication).

4.- SOCIENTIZE participatory experiments, dissemination and networking activities in perspective. Cândida G. Silva, Rui M. M. Brito, António Monteiro, José A. Farias Leal, Adabriand Furtado, Nazareno Andrade, Francisco Brasileiro, Paulo Gama Mota, Caroline Manahl, Teresa Holocher-Ertl, Manuel Pérez Alconchel, Eduardo Lostal Lanza, Carlos Val Gáscon, Francisco Sanz, Fermín Serrano Sanz (2014). Human Computation 1 (2), pp. 119-135.

5.- A Performance/Cost Evaluation for a GPU-Based Drug Discovery Application on Volunteer Computing. D. GUERRERO, Ginés; IMBERNON, Baldomero; PEREZ-SANCHEZ, Horacio; SANZ, Francisco; GARCIA, José M. and CECILIA José M. (2014). BioMed Research International Volume 2014 (2014), Article ID 474219.

6.- Adsorption of probe molecules in pillared interlayered clays: Experiment and computer simulation. A. Gallardo, J.M. Guil, E. Lomba, N.G. Almarza, S.J. Khatib, C. Cabrillo, A. Sanz, y J. Pires (2014). Journal of Chemical Physics 140, 224701.

7.- Heterogeneous networks do not promote cooperation when humans play a Prisoner’s Dilemma. GRACIA LAZÁRO, Carlos, FERRER, Alfredo, RUIZ, Gonzalo, TARANCÓN, Alfonso, CUESTA, José A., SÁNCHEZ, Ángel, MORENO, Yamir (2012). PNAS 109(32), pp. 12922–12926.

8.- Technical Note: An algorithm to calculate the tissue phantom ratio from depth dose in radiosurgery. RAMOS GARCÍA, Luis Isaac, ALMANSA,, Julio F. Medical Phisics, vol. 38, issue 5 (April 2011).

9.- Toward the Discovery of Functional Transthyretin Amyloid Inhibitors: Application of Virtual Screening Methods. SIMõES, Carlos J.V., MUKHERJEE, Trishna, BRITO, Rui M. M., JACKSON, Richard M. (2010). J. Chem. Inf. Model. 50 (10), pp 1806–1820.

10.- Searching for Anti-Amyloid Drugs with the Help of Citizens: the ‘AMILOIDE’ Project on the IBERCIVIS Platform. SIMõES, Carlos J.V., RIVERO, Alejandro, BRITO, R. M. M. (2010). ERCIM News 82, pp. 25-26.

PRINCIPALES PROYECTOS DE INVESTIGACIÓN

1.- Ibercivis.

2.- Socientize.

3.- Open Digital Science.

4.- EGI Engage.

5.-Citizen Science Observatory.

6.- Science in your Mobile.

7.- Aqua .

Colaboradores

- José Alberto Carrodeguas

- Rosa Arias

- Natividad Miguel

- Antonio Lafuente

- Javier Borge-Holthoefer

Análisis de Datos, Visualización Avanzada y Desarrollo de Software

Responsable de la Línea de Investigación:

Gonzalo Ruiz

Investigadores:

Alfredo Ferrer

David Iñiguez

Álvaro Martín

David Muñoz

Francho Bauzá

RESUMEN

El principal objetivo de este equipo es investigar y dar soporte a la investigación siempre que el desarrollo de software o la analítica de datos estén involucrados en el proceso. Para conseguirlo, una de las tareas más importantes que se realizan es la participación en proyectos en los que colaboramos con empresas u otros grupos de investigación. Estas colaboraciones están centradas en temas como BigData, Machine Learning, análisis de Internet, redes sociales, computación distribuida, nuevas tecnologías en educación, etc. Los niveles de colaboración van desde pequeñas contribuciones a empresas locales o grupos de investigación hasta proyectos internacionales.

La otra tarea que realizamos en el BIFI es dar soporte a aquellas investigaciones que se estén llevando a cabo; mejorando y optimizando programas que ya existen, y realizando labores de consultoría sobre las mejores tecnologías y técnicas para el desarrollo.

PUBLICACIONES RELEVANTES

- Targeted Community Merging provides an efficient comparison between collaboration clusters and departmental partitions. F J Bauza, G Ruiz-Manzanares, J Gómez-Gardeñes, A Tarancón, D Íñiguez, Targeted Community Merging provides an efficient comparison between collaboration clusters and departmental partitions, Journal of Complex Networks, Volume 11, Issue 2, April 2023, cnad012, https://doi.org/10.1093/comnet/cnad012

- Analysis of the evolution and collaboration networks of citizen science scientific publications. Pelacho, M., Ruiz, G., Sanz, F. et al. Analysis of the evolution and collaboration networks of citizen science scientific publications. Scientometrics 126, 225–257 (2021). https://doi.org/10.1007/s11192-020-03724-x

- Leaders among the leaders in Economics: a network analysis of the Nobel Prize laureates. José Alberto Molina, David Iñiguez, Gonzalo Ruiz & Alfonso Tarancón (2021) Leaders among the leaders in Economics: a network analysis of the Nobel Prize laureates, Applied Economics Letters, 28:7, 584-589, DOI: 10.1080/13504851.2020.1764478

- Use of open data to improve automobile insurance premium rating. Blesa, D. Iñiguez, R. Moreno, G. Ruiz. International Journal of Market Research 1 – 21 (2019). DOI: 10.1177/1470785319862734.

- Analyzing the potential impact of BREXIT on the European research collaboration network» F. Bauzá, G. Ruiz-Manzanares, L. Pérez-Sienes, A. Tarancón, D. Íñiguez and J. Gómez-Gardeñes. «. Chaos: An Interdisciplinary Journal of Nonlinear Science 30, 063145 (2020); DOI: 10.1063/1.5139019.

- Identification of risk features for complication in Gaucher»s disease patients: A machine learning analysis of the Spanish registry of Gaucher disease. M.M. Andrade-Campos et al. Orphanet Journal of Rare Diseases. 15 – 1, pp. 256 [11 pp]. 2020. ISSN 1750-1172. DOI: 10.1186/s13023-020-01520-7.

- Analysis of academic productivity based on Complex Networks. September 2015, R. Álvarez, E. Cahué, J. Clemente-Gallardo, A. Ferrer, D. Íñiguez, X. Mellado, A. Rivero, G. Ruiz, F. Sanz, E. Serrano, A. Tarancón, Y. Vergara. Scientometrics, September 2015, Volume 104, Issue 3, pp 651-672.

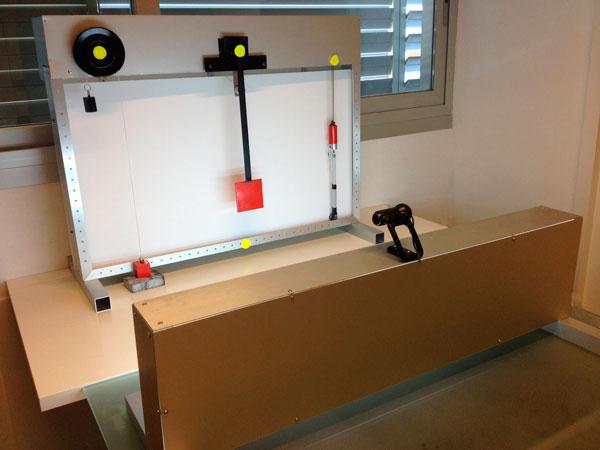

- RRLab: Remote Reality Laboratory to teach mechanics in schools. November 2013, Elisa Cauhé, Alfredo Ferrer, Gonzalo Ruiz, David Íñiguez, Alfonso Tarancón. Chapter 6 of the book “IT Innovative Practices in Secondary Schools: Remote Experiments”, Published by Deusto in 2013. ISBN: 978-84-15772-01-9

- Hadoop Cloud SaaS access via WS-PGRADE adaptation. November 2012, Elisa Cauhé, Arturo Giner, Jaime Ibar, Gonzalo Ruiz, Ruben Vallés. 6th IBERIAN GRID INFRASTRUCTURE CONFERENCE PROCEEDINGS Pages: 161-172 Published: 2013

- Heterogeneous networks do not promote cooperation when humans play a Prisoner‘s Dilemma. 8th June 2012, Carlos Gracia-Lázaro, Alfredo Ferrer, Gonzalo Ruiz, Alfonso Tarancón, José A. Cuesta, Angel Sánchez, and Yamir Moreno. PNAS, Vol. 109, no. 32.

- OptiWeb: An optimization application for steel cut industries ported to the Grid in the framework of PireGrid project. 5th May 2011, “Proceedings of the 5th IBERGRID. ISBN: 978-84-9745-884-9”

- Structural and Dynamical Patterns on Online Social Networks: The Spanish May 15th Movement as a Case Study. 30th July 2011, Javier Borge-Holthoefer, Alejandro Rivero, Íñigo García, Elisa Cauhé, Alfredo Ferrer, Darío Ferrer, David Francos, David Íñiguez, María Pilar Pérez, Gonzalo Ruiz, Francisco Sanz, Fermín Serrano, Cristina Viñas, Alfonso Tarancón, Yamir Moreno . PLoS ONE 6(8): e23883, 2011.

PRINCIPALES PROYECTOS DE INVESTIGACIÓN

- Participación en el experimento «IOT-DITWICS Experiment» de EUHubs4Data, la federación europea de Data Driven Innovation Hubs que pretende consolidarse como la referencia europea en innovación y experimentación impulsadas por datos, fomentando la colaboración entre iniciativas relacionadas en Europa, federando soluciones en un catálogo común global de servicios de datos y compartiendo datos de forma transfronteriza e intersectorial.

- Socio de «EOSC-Synergy», proyecto H2020 cuyo objetivo es ampliar la capacidad y capacidades de la EOSC aprovechando la experiencia, el esfuerzo y los recursos de las infraestructuras digitales nacionales financiadas con fondos públicos.

- “DEEP CODE: Sistema de Deep Learning para caracterización de clientes, predicción y toma de decisiones en el sector asegurador”, proyecto Retos Colaboración con la empresa Codeoscopic S.A, con financiación del Ministerio de Economía y Competitividad.

- “OPTIWASTE – Modelos de machine learning para la previsión y optimización de recursos en la gestión de residuos”, proyecto Retos Colaboración con la empresa Distromel S.A, con financiación de la Agencia Estatal de Investigación.

- Participamos en el Proyecto “Aragón Open Data”, desarrollando la parte social, que consiste en recopilar información de Internet (redes sociales, prensa, etc.) relacionada con Aragón y presentándola en un format estructurado mediante una API para proveer a los ciudadanos herramientas para hacer sus propias aplicaciones.

- Desarrollo de la aplicación llamada Kampal, que crea y estudia las redes formadas por los miembros de la Universidad de Zaragoza a través de sus investigaciones y proyectos. El énfasis se realiza en las relaciones entre personas y en la dinámica de interacción en lugar de en propiedades individuales.

- Desarrollo de una plataforma que incluye distintas unidades didácticas centradas en el studio del Sistema solar a través de gestos gracias al dispositivo Microsoft Kinect. Estas unidades fueron desarrolladas en colaboración con el colegio Juan de Lanuza en el context de su cátefra de innovación.

- Participación en SEPS, Proyecto INNPACTO que trata de predecir diferentes tipos de riesgos en redes eléctricas, y estudiar su impacto si suceden. En este Proyecto colaboramos con empresas y grupos de investigación como Gas Natural Fenosa, Telvent (actualmente Schneider Electric), la Universidad Carlos III o la Universidad de Lérida.

-

RRLab (Laboratorio de Realidad Remota): este Proyecto, pensado con fines educatios, consiste en la creación de una plataforma web para la realización de experimentos de física de forma remota con el objetivo de permitir a los alumnos comparar los resultados teóricos con la realidad.

-

Experimento del Dilema del Prisionero: desarrollamos una plataforma web para la realización de experimentos colectivos para el estudio del comportamiento de las personas dependiendo de la estructura de su organización. Esta plataforma ha sido usada para llevar a cabo dos experimentos diferentes por el momento, y en uno de ellos participaron más de 1300 alumnos en tiempo real. Durante los últimos años hemos hecho diferentes cambios y mejoras en la plataforma para estudiar diferentes parámetros y variables y cómo afectan al comportamiento de la gente.

-

Feelicity: fue un proyecto desarrollado con TEDxZaragoza para la geoetiquetación de momentos felices de los usuarios.

- Colaboración en el ProyectoIbercivis realizando distintas tareas de desarrollo (visualización, web, customización del cliente de BOINC, etc.)

- Participación en el Proyecto STEREA “Optimización de Recursos Hídricos y Telegestión de Regadío” que consistió en una de las primeras aplicaciones web desarrolladas para gestionar los sistemas de riego de diferentes campos con el objetivo de optimizar los recursos, reduciendo los costs, e incrementando la productividad.

- Participación en el proyecto SCIBUS del FPVII programa marco, cuyo objetivo fue crear un portal de propósito genérico con una serie de herramientas para proveer un acceso sencillo y transparente a infraestructuras de computación, datos, red y servicios en Europa, incluyendo clusters, superordenadores, grids, desktop grids, y clouds académicos y comerciales.

-

Estudio del movimiento 15M en Twitter: en este caso, el grupo se encargó de diferentes tareas relacionadas con el estudio como visualización, recogida y procesado de datos, etc.

- Optiweb: este proyecto fue desarrollado a principios de 2011 en colaboración con la empresa Schnell Software, que consistió en la optimización de uno de sus productos de software para que utilizara una infraestructura GRID en su ejecución, mejorando así el rendimiento.

Contactos:

Gonzalo Ruiz, gruiz@bifi.es

Alfredo Ferrer, aferrer@bifi.es

Computación De de Alto Rendimiento y Cloud Computing (HPC-CLOUD)

Responsable de la Línea de Investigación:

David Iñíguez Dieste

Investigadores:

Daniel Martínez Cucalón

John Díaz Laglera

Alfonso Tarancón Lafita

RESUMEN

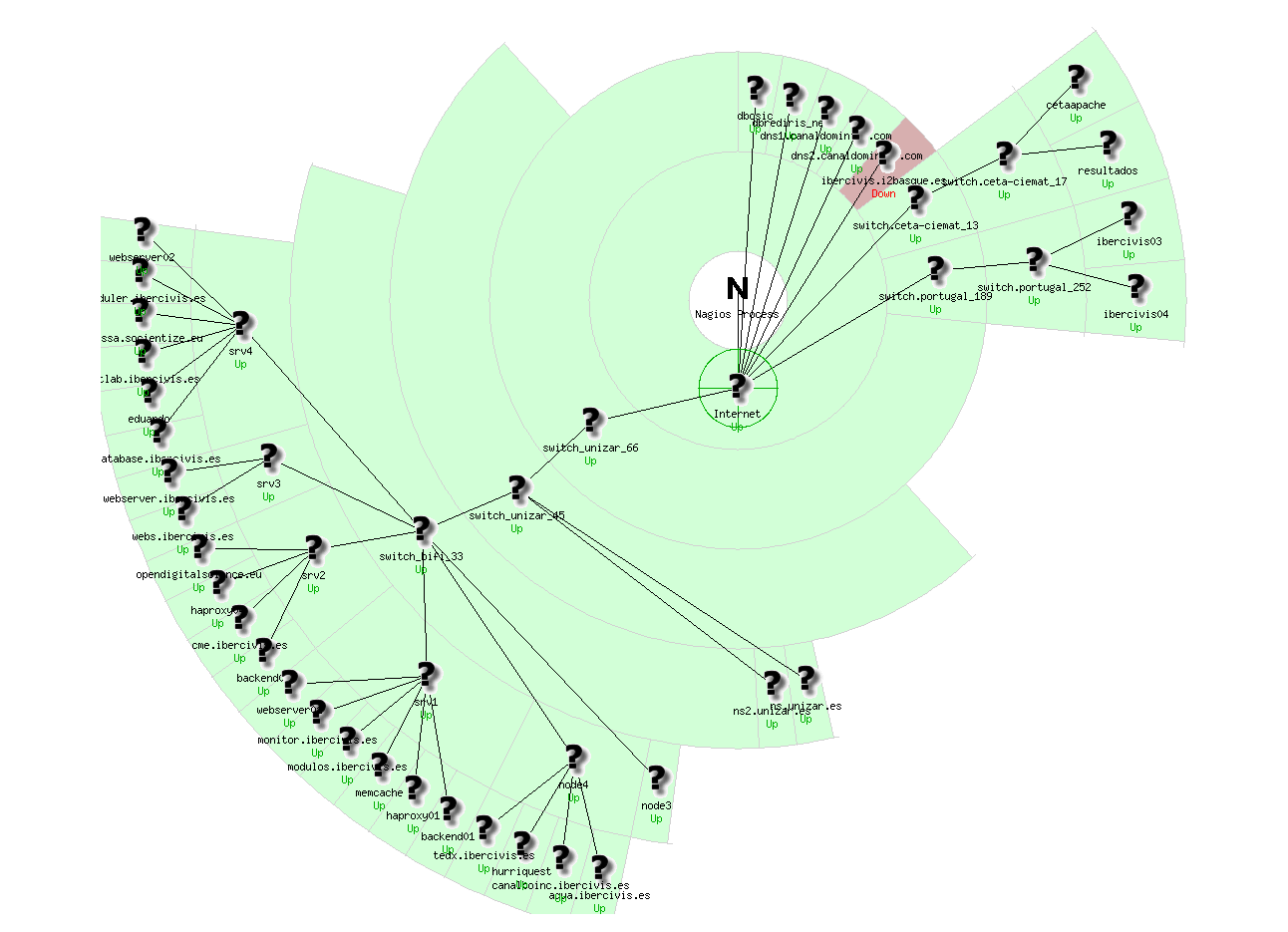

El grupo de Computación de altas prestaciones y Cloud Computing (HPC-Cloud) se estructura en torno a las siguientes líneas de trabajo:

- Participación en proyectos nacionales e internacionales relacionados con tecnologías HPC y Cloud, así como en foros de discusión e integración de dichas tecnologías tanto en investigación como en empresas

- Mantenimiento y soporte de las infraestructuras de supercomputación del BIFI, alojadas en el Centro de Supercomputación de Aragón (CESAR). El personal del grupo cuenta con una larga experiencia en la gestión (operación, monitorización, contabilidad…) y soporte a usuarios de grandes sistemas de cálculo para uso científico, así como en el diseño y mantenimiento de CPDs. El centro alberga dos supercomputadores masivamente paralelos (CIERZO / CAESARAUGUSTA (III) y MEMENTO), la infraestructura cloud COLOSSUS, así como otras infraestructuras de cómputo y almacenamiento de datos.

- Ofrecer un servicio de cálculo y almacenamiento de calidad para los investigadores del Instituto y otros usuarios externos. Los sistemas de cálculo que gestionamos ofrecen anualmente varios millones de horas de cálculo y cientos de terabytes de almacenamiento, tanto a los investigadores del BIFI y sus colaboradores, como a usuarios externos a través de la Red Española de Supercomputación, el programa Hosted Clusters y otros servicios prestados.

- Otros servicios: porting, optimización y paralelización de aplicaciones. Como servicio adicional al soporte básico ofrecido en el uso de nuestros supercomputadores, colaboramos con nuestros usuarios para ayudarles a migrar y hacer más eficientes sus códigos en el entorno HPC.

- Servir como banco de pruebas a empresas y PYMES tanto españolas como europeas, que buscan la adopción de nuevas tecnologías para mejorar sus negocios, ofreciendo recursos computacionales bajo el paradigma IaaS (Infraestructura como Servicio), así como colaborando en el desarrollo y la integración de aplicaciones empresariales al cloud.

- Formación y divulgación. El grupo participa activamente en este tipo de actividades, impartiendo cursos y tutoriales, dirigiendo TFG/TFMs, tutorando prácticas en empresa, gestionando visitas guiadas a nuestras instalaciones…

- Participar en las principales redes de supercomputación a nivel nacional y europeo: RES (Red Española de Supercomputación), Ibergrid (España y Portugal) y EGI-FedCloud, que es una de las infraestructuras distribuidas más grandes a nivel mundial.

PRINCIPALES PROYECTOS DE INVESTIGACIÓN

1.- EuroCC. Creación de una red europea de centros de supercomputación al servicio no solo de la investigación sino también de las empresas. El proyecto pretende fomentar las fortalezas nacionales en competencias de HPC y cubrir las carencias existentes.

2.- EOSC-Synergy. Su objetivo es ampliar las capacidades de EOSC (European Open Science Cloud) aprovechando la experiencia, el esfuerzo y los recursos de las infraestructuras digitales nacionales financiadas con fondos públicos.

3.- Cloudflow. Proyecto europeo en colaboración con las empresas Nabladot y Biocurve. Mejora del proceso de fabricación de calderas de biomasa mediante adaptación de software CFD (Computational Fluid Dynamics) y despliegue en la plataforma CloudFlow.

4.- FORTISSIMO. Proyecto europeo en colaboración con la empresa Schnell Software. Optimización del corte de ferralla en entorno Cloud Computing.

5.- FORTISSIMO 2. Proyecto europeo enfocado a potenciar el uso de las tecnologías Cloud y Big Data por parte de las empresas, en colaboración con las Pymes Nabladot y Kliux (además del proveedor cloud Gompute).

5.- CloudSME (Simulation for manufacturing & engineering). Proyecto europeo en colaboración con las empresas Inycom/Podoactiva. Migración del sistema de escaneo 3D y diseño de plantillas a la plataforma de CloudSME.

7.- SCC-Computing: establecimiento de una colaboración estratégica con los expertos en computación de China para desarrollar los próximos sistemas de cálculo más allá de Tianhe-1A (supercomputador más potente del mundo según el ranking top500 en Noviembre de 2010).

8.- EGI-Engage

9.- SCI-BUS (Scientific gateway Based User Support)

10.- AraGrid

11.- EGI-InSPIRE ( European Grid Infrastructure )

12.- PireGrid

Ordenadores Dedicados

Responsable de la Línea de Investigación:

Sergio Pérez Gaviro

Investigadores:

Alfonso Tarancón

David Iñiguez

Andrés Cruz

Luis Antonio Fernández

Victor Martín Mayor

Juan Jesús Ruíz Lorenzo

Antonio Gordillo

Javier Moreno Gordo

RESUMEN

Los ordenadores se han convertido en una herramienta esencial en nuestras vidas cotidianas. Simples actividades rutinarias como la compra de un billete de tren o el envío de un mensaje a alguien requieren el uso de ordenadores convencionales que, por supuesto, también juegan un papel muy importante en tareas más complejas, como transferencias bancarias o gestión de redes eléctricas, por ejemplo. Por otra parte, estos equipos también han hecho posibles muchos avances en la ciencia y en la actualidad están claramente presente en un amplio conjunto de áreas científicas. De hecho, muchas instituciones de todo el mundo dedican una enorme cantidad de dinero y esfuerzo humano para construir clusters de computadores (véase, por ejemplo, www.top500.org/lists/ para una lista detallada de los superordenadores más potentes del mundo).

Para algunos problemas específicos, sin embargo, los ordenadores convencionales no son suficientes. Se necesitarían miles de años para realizar algunos cálculos particulares. Así, en el marco de la supercomputación se encuentran los ordenadores dedicados (o de propósito especial), que son desarrollados y diseñados para realizar cálculos intensivos de carácter específico.

El desarrollo de este tipo de ordenadores es precisamente el objetivo de esta línea de investigación. Así, gracias a una exitosa colaboración científica entre los investigadores del BIFI (Universidad de Zaragoza), Universidad Complutense de Madrid, Universidad de Extremadura, Università degli Studi di Roma «La Sapienza» y Università di Ferrara, en 2008 nació el superordenador Janus, sistema informático basado en chips de lógica programable (FPGAs), modular, masivamente paralelo y reconfigurable para la computación de alto rendimiento científico. Su arquitectura reconfigurable permite a Janus proporcionar capacidad de cálculo para diferentes aplicaciones científicas en Física, en Química o en Biología. La colaboración Janus ha centrado sus esfuerzos en el estudio y simulación de vidrios de espín, paradigma de los sistemas complejos.

Janus está compuesto por 16 placas base. En cada una de ellas, se tiene una cuadrícula bidimensional de 4×4 procesadores basados en FPGA y dispuestos con condiciones de contorno periódicas. Cada uno de estos procesadores se denomina SP (Simulation Processor) y lleva a cabo las simulaciones. Una FPGA adicional actúa como una pasarela (IOP – Input Output Processor) y está a cargo de todas las conexiones internas y las comunicaciones externas. Todos los módulos FPGA son Xilinx Virtex4-LX200.

Janus II es la nueva generación ubicada en el BIFI desde 2013. Siguiendo la misma filosofía que en Janus, Janus II está compuesto nuevamente por 16 placas base. En cada placa, 16 procesadores FPGA de la última generación disponible en su momento (Xilinx Virtex 7-XC7VX485T) se encuentran vinculados y con condiciones de contorno periódicas. Se llaman SP (Simulation Processor), ya que están a cargo de las simulaciones. Todos los de SP de cada placa están controlados por un ordenador insertado en la propia tarjeta que llamamos CP (Control Processor) que ejecuta el sistema operativo Linux. Estos CP gestionan todos los procesadores FPGA para las simulaciones, el control y seguimiento de su estado. El CP utiliza un sistema disponible en el mercado, Computer-on-Module (COM), basado en un procesador Intel Core i7; se conecta a través de la interfaz PCIe a un procesador de entrada-salida (IOP) construido con otra FPGA. La IOP maneja todas las conexiones a los SP, controlando el procedimiento de configuración y su funcionamiento, y el seguimiento de su estado. La arquitectura Janus II incluye también mejoras en las comunicaciones, permitiendo la interconexión entre todas las placas base, y también amplía 100 veces la memoria disponible.

Janus II fue construido gracias a fondos FEDER: Ministerio de Economía y Competitividad (Gobierno de España), Gobierno de Aragón, Unión Europea.

Más información en http://www.janus-computer.com

PUBLICACIONES RELEVANTES

1.-Janus Collaboration: M. Baity-Jesi; E. Calore; A. Cruz; L.A. Fernandez; J. M. Gil-Narvion; A. Gordillo-Guerrero; D. Iñiguez; A. Maiorano; E. Marinari; V. Martin-Mayor; J. Monforte-Garcia; A. Muñoz Sudupe; D. Navarro; G. Parisi; S. Perez-Gaviro; F. Ricci-Tersenghi; J. J. Ruiz-Lorenzo; S.F. Schifano; B. Seoane; A. Tarancon; R. Tripiccione; D. Yllanes. «Aging rate of spin glasses from simulations matches experiments«, arXiv:1803.02264. Phys. Rev. Lett. 120, 267203 (2018).

2.-Janus Collaboration: M. Baity-Jesi; E. Calore; A. Cruz; L.A. Fernandez; J. M. Gil-Narvion; A. Gordillo-Guerrero; D. Iñiguez; A. Maiorano; E. Marinari; V. Martin-Mayor; J. Monforte-Garcia; A. Muñoz Sudupe; D. Navarro; G. Parisi; S. Perez-Gaviro; F. Ricci-Tersenghi; J. J. Ruiz-Lorenzo; S.F. Schifano; B. Seoane; A. Tarancon; R. Tripiccione; D. Yllanes. «Matching Microscopic and Macroscopic Responses in Glasses«. arXiv:1704.07777. Phys. Rev. Lett. 118, 157202 (2017).

3.-Janus Collaboration: M. Baity-Jesi; E. Calore; A. Cruz; L.A. Fernandez; J. M. Gil-Narvion; A. Gordillo-Guerrero; D. Iñiguez; A. Maiorano; E. Marinari; V. Martin-Mayor; J. Monforte-Garcia; A. Muñoz Sudupe; D. Navarro; G. Parisi; S. Perez-Gaviro; F. Ricci-Tersenghi; J. J. Ruiz-Lorenzo; S.F. Schifano; B. Seoane; A. Tarancon; R. Tripiccione; D. {\mbox Yllanes}. «A statics-dynamics equivalence through the fluctuation-dissipation ratio provides a window into the spin-glass phase from nonequilibrium measurements«. arXiv:1610.01418. Proc. Natl. Acad. Sci. USA vol. 114 no. 8, 1838-1843 (2017).

4.- Janus Collaboration: M. Baity-Jesi, R. A. Baños, A. Cruz, L. A. Fernandez, J. M. Gil-Narvion, A. Gordillo-Guerrero, D. Iñiguez, A. Maiorano, F. Mantovani, E. Marinari, V. Martin-Mayor, J. Monforte-Garcia, A. Muñoz Sudupe, D. Navarro, G. Parisi, S. Perez-Gaviro, M. Pivanti, F. Ricci-Tersenghi, J. J. Ruiz-Lorenzo, S. F. Schifano, B. Seoane, A. Tarancon, R. Tripiccione, D. Yllanes. «Janus II: a new generation application-driven computer for spin-system simulations». arXiv:1310.1032. Computer Physics Communications 185, 550-559 (2014)

5.- Janus Collaboration: R. A. Banos, A. Cruz, L. A. Fernandez, J. M. Gil-Narvion, A. Gordillo-Guerrero, M. Guidetti, D. Iniguez , A. Maiorano, F. Mantovani, E. Marinari , V. Martin-Mayor, J. Monforte-Garcia, A. Munoz Sudupe, D. Navarro, G. Parisi, M. Pivanti, S. Perez- Gaviro, F. Ricci-Tersenghi, J. J. Ruiz-Lorenzo, S. F. Schifano, B. Seoane, A. Tarancon, R. Tripiccione, D. Yllanes. «An FPGA-based supercomputer for statistical physics: the ‘weird’ case of Janus». Book Chapter in: «High-Performance Computing using FPGAs», pp. 481-506 (2013), University of Glasgow, Publisher: Springer.

6.- Janus Collaboration: M. Baity-Jesi, R. A. Banos, A. Cruz, L. A. Fernandez, J. M. Gil-Narvion, A. Gordillo-Guerrero, M. Guidetti, D. Iniguez, A. Maiorano, F. Mantovani, E. Marinari, V. Martin-Mayor, J. Monforte-Garcia, A. Munoz Sudupe, D. Navarro, G. Parisi, M. Pivanti, Perez-Gaviro, F. Ricci-Tersenghi, J. J. Ruiz-Lorenzo, S. F. Schifano, B. Seoane, A. Tarancon, P. Tellez, R. Tripiccione, D. Yllanes. «Reconfigurable computing for Monte Carlo simulations: results and prospects of the Janus project». arXiv:1204.4134, The European Physical Journal Special Topics 210, 33 (2012).

7.- Janus Collaboration: F. Belletti, M. Cotallo, A. Cruz, L. A. Fernandez, A. Gordillo, A. Maiorano, F. Mantovani, E. Marinari, V. Martin-Mayor, A. Muñoz-Sudupe, D. Navarro, S. Perez-Gaviro, M. Rossi, J. J. Ruiz-Lorenzo, S. F. Schifano, D. Sciretti, A. Tarancon, R. Tripiccione, J. L. Velasco. «JANUS: an FPGA-based System for High Performance Scientific Computing». arXiv:0710.3535v2, Computing in Science & Engineering 11-1, 48-58 (2009).

8.- Janus Collaboration: F. Belletti, M. Cotallo, A. Cruz, L. A. Fernandez, A. Gordillo, A. Maiorano, F. Mantovani, E. Marinari, V. Martin-Mayor, A. Muñoz-Sudupe, D. Navarro, S. Perez-Gaviro, J. J. Ruiz-Lorenzo, S. F. Schifano, D. Sciretti, A. Tarancon, R. Tripiccione, J. L. Velasco. «Simulating spin systems on IANUS, an FPGA-based computer.» arXiv:0704.3573, Computer Physics Communications 178 (3), p.208-216, (2008).

9.- Janus Collaboration: F. Belletti, I. Campos, A. Cruz, L. A. Fernandez, S. Jimenez, A. Maiorano, F. Mantovani, E. Marinari, V. Martin- Mayor, D. Navarro, A. Muñoz-Sudupe, S. Perez Gaviro, G. Poli, J. J. Ruiz-Lorenzo, F. Schifano, D. Sciretti, A. Tarancon, P. Tellez, R. Tripiccione, J. L. Velasco. «Ianus: an Adaptative FPGA Computer.» arXiv:0507270, Computing in Science & Engineering, January/February 2006, Volume 8, N 1, p. 41.

10.- Janus Collaboration: M. Baity-Jesi, R.A. Baños, A. Cruz, L.A. Fernandez, J.M. Gil-Narvion, A. Gordillo-Guerrero, M. Guidetti, D. Iñiguez, A. Maiorano, F. Mantovani, E. Marinari, V. Martin-Mayor, J. Monforte-Garcia, A. Muñoz-Sudupe, D. Navarro, G. Parisi, S. Perez-Gaviro, M. Pivanti, F. Ricci-Tersenghi, J. Ruiz-Lorenzo, S.F. Schifano, B. Seoane, A. Tarancon, P. Tellez, R. Tripiccione , D. Yllanes. «Spin glass simulations on the Janus architecture: A desperate quest for strong scaling». Parallel Processing Workshops, Euro-Par 2012, LNCS Volume 7640 LNCS, 2013, Pages 528-537

11.- Janus Collaboration: M. Baity-Jesi, R. A. Banos, A. Cruz, L. A. Fernandez, J. M. Gil-Narvion, A. Gordillo-Guerrero, M. Guidetti, D. Iniguez, Maiorano, F. Mantovani, E. Marinari, V. Martin-Mayor, J. Monforte-Garcia, A. Munoz Sudupe, D. Navarro, G. Parisi, M. Pivanti, S. Perez- Gaviro, F. Ricci-Tersenghi, J. J. Ruiz-Lorenzo, S. F. Schifano, B. Seoane, A. Tarancon, P. Tellez, R. Tripiccione, D. Yllanes. «Janus2: an FPGA-based Supercomputer for Spin Glass Simulations». ICS12 Workshop proceedings (http://hpc.pnl.gov/conf/ICS2012/)

12.- Janus Collaboration: Belletti, F; Cruz, A; Fernandez, LA; Gordillo-Guerrero, A; Guidetti, M; Maiorano, A; Mantovani, F; Marinari, E; Martin- Mayor, V; Sudupe, AM; Navarro, D; Parisi, G; Perez-Gaviro, S; Ruiz-Lorenzo, JJ; Schifano, SF; Sciretti, D; Tarancon, A; Tripiccione, R; Yllanes,D. «Nonequilibrium spin glass dynamics with Janus». AIP Conference Proceedings 1091 (2009) 228-230.

13.- Janus Collaboration: Belletti, F; Cotallo, M; Cruz, A; Fernandez, LA; Gordillo-Guerrero, A; Guidetti, M; Maiorano, A; Mantovani, F; Marinari, E; Martin-Mayor, V; Sudupe, AM; Navarro, D; Parisi, G; Perez-Gaviro, S; Rossi, M; Ruiz-Lorenzo, JJ; Saenz-Lorenzo, JF; Schifano, SF; Sciretti, D; Tarancon, A; Tripiccione, R; Velasco, JL; Yllanes, D; Zanier, G. «Monte Carlo simulations for statistical physics: Janus». Proceedings Paper: Nuovo Cimento B 123 (2008) 972-974

14.- Janus Collaboration: F. Belletti, M. Cotallo, A. Cruz, L. A. Fernández, A. Gordillo, A. Maiorano, F. Mantovani, E. Marinari, V. Martín-Mayor, A. Muñoz-Sudupe, D. Navarro, S. Perez-Gaviro, M. Rossi, J. J. Ruiz-Lorenzo, S. F. Schifano, D. Sciretti, A. Tarancón, R. Tripiccione, J. L. Velasco. «IANUS: Scientific Computing on an FPGA-Based Architecture». Parallel Computing: Architectures, Algorithms and Applications, Proceedings of the International Conference ParCo 2007 (C. Bishof, M. Buecker, P. Gibbon, G. Joubert, T. Lippert, B. Mohr, F. Peters editors), Publication Series of the John Von Neumann Institute for Computing, 38 (2007) 553-560. Reprinted in: Advances in Parallel Computing, 15 (2008), 553-560.

Responsable de la Línea de Investigación:

Carmen Pérez-Llantada

Investigadores:

Oana Maria Carciu

Alfonso Ollero Gavín

Alberto Vela Rodrigo

Ana Cristina Vivas Peraza

Rosana Villares Maldonado

María José Luzón Marco

Ignacio Guillén Galve

Sofía Albero Posac

Miguel Ángel Vela Tafalla

María de los Ángeles Velilla Sánchez

Miguel Ángel Benítez Castro

RESUMEN

Los recursos y la infraestructura computacional de los medios digitales, incluyendo las redes sociales, facilitan la creación y el intercambio de conocimiento científico no solo entre investigadores especialistas en las disciplinas STEM sino también con el público en general. Esta línea de investigación se centra en lo que denominamos Ciencia 2.0, es decir, en cómo se construye, difunde y comunica la ciencia a través de recursos y medios digitales y cómo se co-construye el conocimiento científico mediante el diálogo dentro de la comunidad científica y el diálogo entre los investigadores y otros grupos de interés (science stakeholders). En esta línea investigamos también por qué los investigadores quieren o tienen que comunicar la ciencia en abierto, las políticas vigentes que lo impulsan y las percepciones de los investigadores al respecto. También investigamos los repertorios de géneros digitales (escritos y orales) que actualmente utilizan los investigadores para acercar la ciencia a audiencias diversificadas y contribuir así a la democratización del conocimiento y al fomento y desarrollo de la alfabetización científica y digital de la sociedad.

Desarrollamos análisis cuantitativos y cualitativos sobre generación de nuevo conocimiento, difusión del conocimiento mediante acceso abierto, desarrollo de la alfabetización digital de los investigadores, estrategias de comunicación para acercar la ciencia a audiencias no especializadas, así como estudios que nos permiten identificar el papel del plurilingüismo y los retos y las necesidades lingüísticas de los investigadores en las áreas STEM para abordarlos y fortalecer sus capacidades de comunicación, uno de los requisitos competenciales para la formación de investigadores noveles y experimentados según los descriptores EURAXESS de la European Commission. A nivel metodológico, empleamos herramientas propias de las humanidades digitales para el análisis de datos textuales. Nuestro énfasis está en el uso de técnicas de lingüística de corpus, de procesamiento de datos lingüísticos y de minería de textos a pequeña y gran escala, así como técnicas de lingüística computacional y técnicas etnometodológicas. Estos métodos nos permiten identificar tendencias en la comunicación de Ciencia 2.0 multilingüe y abordar los problemas que conlleva la utilización de repertorios de lenguas para comunicar y difundir ciencia con y para la sociedad.

Además, nuestra investigación está alineada con varios de los objetivos de desarrollo sostenible (ODS) de la Agenda 2030 de las Naciones Unidas, en concreto los propuestos por la World Federation of Science Journals: calentamiento global y lo que pueden hacer las sociedades para adaptarse al cambio climático, salud mental, ciencia y salud global y la crisis global de biodiversidad. Para ello, utilizamos corpus de textos electrónicos para llevar a cabo caracterizaciones descriptivas de distintos géneros que se emplean para comunicar ciencia en medios digitales, con especial atención a los aspectos fraseológicos, discursivos, pragmáticos y retóricos, así como rasgos de complejidad léxica y sintáctica y de registro y estilo en la lengua o lenguas utilizadas. También analizamos ensamblajes de géneros digitales (por ejemplo, cadenas de géneros, sistemas de géneros y ecologías de géneros) y los recursos semióticos que los investigadores están utilizando en la actualidad para difundir ciencia y que incluyen tanto géneros monomodales como multimodales y géneros en una o varias lenguas. La transferencia de esta investigación se enmarca en la innovación docente, el asesoramiento en materia de políticas científicas y políticas lingüísticas, así como en la formación permanente en comunicación profesional para recursos humanos en el ámbito de la investigación STEM.

PUBLICACIONES RELEVANTES

1. Genres and languages in science communication: The multiple dimensions of the science-policy interface. Pérez-Llantada, C. (2021). Language & Communication, 78, 65-76.

2. Research Genres across Languages. Multilingual Science Communication Online. Pérez-Llantada, C. (2021). Cambridge: Cambridge University Press.

3. Grammar features and discourse style in digital genres: The case of science-focused crowdfunding projects. Pérez-Llantada, C. (2021). Revista Signos. Estudios de Lingüística, 54(105), 73-96.

4. Science on the Internet. Old Genres Meet New Genres. Luzón, M.J. & Pérez-Llantada, C. eds. (2019). Amsterdam: John Benjamins.

5. Bringing into focus multilingual realities: Faculty perceptions of academic languages on campus. Pérez-Llantada, C. (2018). Lingua 212, 30-43.

6. How is the digital medium shaping research genres? Some cross-disciplinary trends. Pérez-Llantada, C. (2016). ESP Today. Journal of English for Specific Purposes at Tertiary Level, 4, 22-42.

7. Genres in the forefront, languages in the background: The scope of genre analysis in language-related scenarios Pérez-Llantada, C. (2015). Journal of English for Academic Purposes, 19, 10-21.

8. Academic Englishes: A standardised knowledge?. Mauranen, A., C. Pérez-Llantada and J. M. Swales. (2020). In A. Kirkpatrick (ed.) The World Englishes Handbook, 2nd edition. London, New York: Routledge. (pp. 659-676).

9. Formulaic language in L1 and L2 expert academic writing: Convergent and divergent usage. Pérez-Llantada, C. (2014). Journal of English for Academic Purposes, 14, 84-94.

10. The Article of the Future: Strategies for genre stability and change. Pérez-Llantada, C. (2013). English for Specific Purposes 32.4, 221-235.

11. Scientific Discourse and the Rhetoric of Globalization. The Impact of Culture and Language. Pérez-Llantada, C. (2012). London & New York: Continuum.

12. English as an International Language of scientific publication: A study of attitudes. Ferguson, G., C. Pérez-Llantada & R. Plo. (2011). World Englishes 30.1, 41-59.

PRINCIPALES PROYECTOS DE INVESTIGACIÓN

- Digital genres and Open Science: An analysis of the processes of hybridization, innovation and generic interdiscursivity (PID2019-105655RB-I00), Plan Nacional I+D+i Ministerio de Innovación y Ciencia, vigente hasta 2024.

- Ecologies of genres and ecologies of languages: An analysis of the dynamics of scientific communication at local, cross-border and international levels” (FFI2015-68638-R MINECO/FEDER, EU) (2015-2020), Plan Nacional I+D+i Ministerio de Economía y Competitividad y Fondos FEDER.

COLABORADORES

International group coordinators:

- Dacia Dressen-Hammouda, Université Clermont Auvergne (France)

- Julio Gimenez, University of Westminster, London (United Kingdom)

- Laura-Mihaela Muresan, Bucharest University of Economic Studies (Romania)

- Pavel Zemliansky, Oslo Metropolitan University (Norway)

CONTACTO

digital.science.BIFI@unizar.es

Responsable de la Línea de Investigación:

Gerardo Sanz Sáiz

Investigadores:

Javier López Lorente

Ana Carmen Cebrián Guajardo

Pedro Mateo Collazos

Luis Mariano Esteban Escaño

Miguel Lafuente Blasco

RESUMEN

La investigación del grupo de Modelos Estocásticos (MODES) se estructura en torno a dos líneas de trabajo:

– Análisis de datos extremos con aplicaciones en Climatología. El objetivo principal es el desarrollo de herramientas probabilísticas y estadísticas para modelizar observaciones extremas, especialmente las relacionadas con la temperatura y la precipitación. El análisis de este tipo de series requiere modelos espacio-temporales, que se desarrollan en un marco bayesiano. Las aplicaciones se centran en el análisis de series en el valle del Ebro y España, pero los modelos pueden extrapolarse a otras regiones.

– Modelos predictivos en Medicina. El grupo ha desarrollado modelos estadísticos en oncología y ginecología, incluyendo calculadoras online para predecir la evolución de los pacientes. También hemos construido modelos para utilizarlos como herramientas de ayuda a la toma de decisiones en la gestión de hospitales. En concreto, hemos desarrollado un modelo multiestado para predecir la ocupación de hospitales y UCI durante una pandemia, como COVID, que incluye una herramienta independiente de libre acceso. El grupo también trabaja en el análisis de modelos estocásticos para la logística del proceso de producción de componentes sanguíneos, con el fin de minimizar las tasas de caducidad y maximizar la frescura.

PUBLICACIONES RELEVANTES

1.Bayesian variable selection in Generalized Extreme Value regression: Modeling annual maximum temperature. Castillo-Mateo, J.; Asín, J.; Cebrián, AC.; Mateo-Lázaro, J.; Abaurrea, J. 2023. Mathematics, 11(3) 759.

2.A Multistate model and its standalone tool to predict hospital and ICU occupancy by patients with COVID-19. Lafuente, M, López FJ.; Mateo, P.; Cebrián, AC.; Asín, J.; Moler, JA.; Borque, A.; Esteban, LM.; Pérez, A. and Sanz, G. 2023. Heliyon, 9(2) e13545.

3.Testosterone recovery after androgen deprivation therapy in prostate cancer: building a predictive model. Borque, Á; Estrada, F; Esteban, LM; Gil, MJ; Sanz, G. 2022. The world journal of men’s health, 34,588-598.

4.Spatial Modeling of Day-Within-Year Temperature Time Series: An Examination of Daily Maximum Temperatures in Aragón, Spain. Castillo-Mateo, J.; Lafuente, M.; Asín, J.; Cebrián, AC.; Gelfand, A.; Abaurrea, J.2022. JABES. 27, pp. 487–505.

5.Spatio-temporal analysis of the extent of an extreme heat event. Cebrián, AC.; Asín, J.; Gelfand, A.; Schliep, E; Castillo-Mateo,J; Beamonte, A; Abaurrea, J. 2022. SERRA. 36, pp. 2737–2751.

6.Record tests to detect non-stationarity in the tails with an application to climate change. Cebrián, AC.; Castillo, J.; Asín, J. 2022. SERRA. 36, pp.313–330.

7.Machine Learning Algorithm to Predict Acidemia Using Electronic Fetal Monitoring Recording Parameters. Esteban, J; Castán, B; Castán, S; Chóliz, M; Asensio, C; Laliena, A; Sanz-Enguita, G; Sanz, G; Esteban, LM; Savirón, R. 2022. Entropy, 24, 68.

8.Performance measures of nonstationary inventory models for perishable products under the EWA policy. Gorria, C., Lezaun, M., & López, F. J. 2022. European Journal of Operational Research. 303(3). 1137-1150.

9.Near-Record Values in Discrete Random Sequences. Lafuente, M; Gouet, R; Lopez, FJ; Sanz, G. 2022. Mathematics, 10, 2442.

10.Incorporating a New Summary Statistic into the Min–Max Approach: A Min–Max–Median, Min–Max–IQR Combination of Biomarkers for Maximising the Youden Index. Aznar, R; Esteban, LM.; Sanz, G; Hoyo, R; Savirón, R. 2021. Mathematics, 9, 2497.

11.Analyzing dependence between point processes in time using IndTestPP. Cebrián, AC.; Asín, J. 2021. R JOURNAL. 13 -1, pp. 499 – 515.

12.Long-term spatial modelling for characteristics of extreme heat events JRSS. Series A. Schliep, E.M.; Gelfand, A.; Abaurrea, J.; Asín, J.; Beamonte, MA.; Cebrián, AC.. 2021.Statistics in Society. 84(3), 1070-1092.

13.Forecasting high-frequency river level series using double switching regression with ARMA errors. Cebrián, AC.; Salillas, R. 2021.Water resources Management. 35, pp. 229 – 313.

14.Impact of implementing pathogen reduction technologies for platelets on reducing outdates. Gorria, C., Labata, G., Lezaun, M., López, FJ., Perez Aliaga, AI., & Pérez Vaquero, MÁ. 2020. Vox sanguinis, 115, 167-173.

15.Exact and asymptotic properties of delta-records in the linear drift model. Gouet, R; Lafuente, M; Lopez, FJ; Sanz, G. 2020. JOURNAL OF STATISTICAL MECHANICS: THEORY AND EXPERIMENT. P103201.

16.Statistical Inference for the Weibull Distribution Based on d-Record Data. Gouet, R; Lopez, FJ; Maldonado, L; Sanz, G. 2020. SYMMETRY-BASEL. 12.

PRINCIPALES PROYECTOS DE INVESTIGACIÓN

- (2022-2024) Project code: TED2021-130702B-I00. Agencia Estatal de Investigación. Modelización y proyección de récords y extremos medioambientales para evaluación del cambio climático. Aplicación en la cuenca del Ebro y en Pirineos. IP: Gerardo Sanz and Ana Carmen Cebrián.

- (2020-2023) Project code: PID2020-116873GB-I00. Agencia Estatal de Investigación. Modelos estocásticos para estimación y predicción en medicina y extremos medioambientales. IP: F. Javier López and Ana Carmen Cebrián

- (2003-). Project code: E46_20R. Gobierno de Aragón. Modelos Estocásticos. Grupo de investigación de referencia DGA

- (2013-2015) Project code: 2013/0386. Diputación Provincial de Zaragoza Desarrollo de un proyecto de producción y difusión de estadística local. IP: F. Javier López and Gerardo Sanz

- 2013. Project code: 2013/0412. Comercial RAFER S.L. Construcción de modelos estocásticos para predecir la evolución a LMA y la respuesta a tratamiento en pacientes con SMD. IP: F. Javier López

COLABORADORES